在5月18日举行的第五届上海创新创业青年50人论坛上,月之暗面创始人杨植麟发表演讲,分享了他的创业初衷、心得,以及对人工智能技术发展的看法。

蓝驰创投是月之暗面的早期投资人。

杨植麟出生于1993年,是国内大模型企业月之暗面创始人,本科毕业于清华大学计算机系 ,博士毕业于卡内基梅隆大学计算机学院。曾就职于Facebook、谷歌等公司,在多个国际顶级AI会议发表论文20余篇。

对于创业时机的选择,杨植麟提到了两个主要因素,政府支持、风投支持以及创新人才,是其中最重要的创业环境的因素,而AI再次兴起、“第一性原理”对他的启发是另一个主要因素。

他认为,AI的发展得益于互联网、Transformer架构和半导体技术的发展,这三个天时地利的因素共同促成了AI to C的机会,“这三个天时地利,就是刚好发展到阶段,可能你早几年、晚几年,都不是最好的时机,刚好就是2022年底。”他提到,“互联网最大的价值,其实是为AI积累了二十多年的数据。”

杨植麟指出,多模态技术和数据瓶颈的突破是AGI发展的关键,需要通过生成数据来经营和扩展数据集。他认为,算力的提升和算力的利用率或效率是决定模型性能的两个关键因素。

杨植麟提到,长上下文技术类似于计算机时代的内存,对于处理复杂任务和提供个性化服务至关重要。今年3月,杨植麟的Kimi智能助手宣布支持200万字无损上下文,开启了国内大模型的长文本之战。

对于AI对打工人效率的提升,杨植麟预测,AI将逐渐处理更复杂的任务,并可能在工作流程中扮演更重要的角色,“可能从现在的比如说1%,未来有可能提升到90%甚至99%以上。”。

杨植麟称,大模型和互联网的开发方式完全不一样。互联网像“在一个地方种树”,是一种规划式的发展,很少遇到技术瓶颈;而大模型却类似“直接把整片森林包下来”,要去更多关注一些基础能力,然后让模型去涌现。

而对于创业,杨植麟坦言,希望把更多的精力、优先级放在“爬楼梯”上,而不仅仅只是去“看风景”,以此回应创业过程中对技术研发和商业变现之间的平衡取舍。“模型的能力还会有非常大的提升空间,我们今天可能还是在产业的开端,才刚刚做到10的25次方浮点数运算,那接下来很有可能会有10的26、27、28甚至29次方出现。”

以下为杨植麟演讲全文:

杨植麟:各位领导、各位朋友,非常荣幸今天有机会能在这里跟大家分享我们的一些思考和进展。

人工智能在过去十年的时间里面发展非常迅速。大约2017年,Transformer架构被提出来,一开始的时候,这还是一个翻译的模型,它的应用的范围比较有限。

2018年,我开始跟Google的几个同事,开始训练基于Transformer的语言模型,所以也是最早训练了比RNN可能要更好的Transformer的语言模型。2019年,我们就选择回国创业,这里面我觉得当时有两个最主要的因素。

第一个因素,就是环境。我们当时看到了巨大的机会,包括政府支持,包括风险投资的支持,以及包括中国过去几十年的教育系统的发展,培养出来的这些人才,使得我们真的有办法去做AI的创业。培养的一批新的人才,使得我们能够去做AGI的事情。我觉得这可能是当时第一个重要的条件。

第二个比较重要的条件,我觉得是我们看到AI其实是有非常大的机会,就是所谓第一性原理。

我比较受到启发的一个故事,其实是,大概1970年代,就那个时候英特尔发布了最早的这种微处理器,但那个时候最早刚发布出来的时候,其实没有什么作用,基本上看不到什么商业价值,能跑的应用非常有限。

但是,比尔·盖茨,还有他的朋友保罗·艾伦,但他们看到一个非常有意思的点就是,虽然你芯片当时还没有什么作用,但是基本上,他们观察到了,摩尔定律就是每N个月算力就能翻一倍,他们由此推测出来,其实虽然你现在没什么用,但几十年后,有可能每一个家庭里面都会有一个个人电脑——后来也成为一个事实。

所以当时我们站在2019年的时候去看人工智能,也大概是这样的一个感受,就是你的模型可能一直在变大,但是他又没有达到一个真正每个人都能用的状态。但是我们相信它的第一性原理,就是所谓的Scaling Law规模化定律。可能每N个月模型计算量也会有指数级的提升,通过计算量指数级的提升,去达到智能能力的提升,最终不管是在手机上,还是在新的硬件形态上,有可能会有能够帮助到每一个人的AI出现。

所以,我们当时基于这两个条件,选择来做事情。

很多时候,其实技术的发展非常神奇,就是很多情况下,新的技术是建立在原来的技术的基础上,是人类文明科技树的发展过程。

我们看到为什么像2022年底GPT-4发布的时候,它其实是AGI一个巨大里程碑,因为它做到了以前从来不可能做到的效果,但效果它是有一个前很重要的前提,我觉得也是一个天时地利的一个结果。

首先是物联网。互联网发展了二十多年,本身创造了很大的价值。但是,很可能比如说再过三四十年,我们回过头来看,发现互联网最大的价值,其实是为AI积累了二十多年的数据。

所以我们现在能够在网上获取,比如说十几T的高质量token,完全是得益于互联网的发展。

然后第二个,就是Transformer架构的提出。也是一个很大的变量,在此之前其实从来没有一个可以被规模化的网络结构的出现。

第三个很重要的点是,半导体的发展,包括就是整个软件生态的发展,使得说我们能够去训练10的25次方次浮点数运算这样的模型。

所以这三个天时地利,就是刚好发展到阶段,可能你早几年、晚几年,都不是最好的时机,刚好就是2022年底。

所以在世界上出现了可能第一次有这种AI to C的机会。就有点像微处理器在在上个世纪七八十年代的发展,突然到某一刻,你发现所有的条件都成立了,它就可以开始变成一个面向大部分的C端用户,让普通用户可以去使用的这样的一个技术,而且可能接下来随着规模化定律的持续发展,还能够再进一步提升能力。

所以我们总结下来就是说,如果去看通用人工智能发展,它其实最底层还是第一性原理,就是通过去预测下一个token,规模化定律,它本质上是在对数据做更好的无损压缩,就有点像计算机时代的摩尔定律,定律支撑了几十年的计算机发展。越来越多的应用,最底层的规律其实就是规模化定律。

然后,再往上一层其实有两个非常重要的技术问题,也是我觉得现在可能所有的AGI公司最关注的技术问题。

第一层就是怎么能够去统一,大家可能最近看到像类似GPT-4o这样的技术,大家都在往多模态的方向去发展,其实本质上是想用多模态的技术,进一步去提升智能,因为可能文本数据一定程度上已经走到了一个天花板。

第二层就是怎么能够通过生成数据去经营。打破数据瓶颈能够让越来越多的数据加入训练,规模化定律才能持续往下去发展。

第三层可能就是一些更加具体的技术问题。

我认为,第一层面的已经被发现,而且可能很大程度被验证了,现在可能AI的核心技术是聚焦在第二层,如果能够把第二层解决好,其实可以创造出来非常多的新机会。

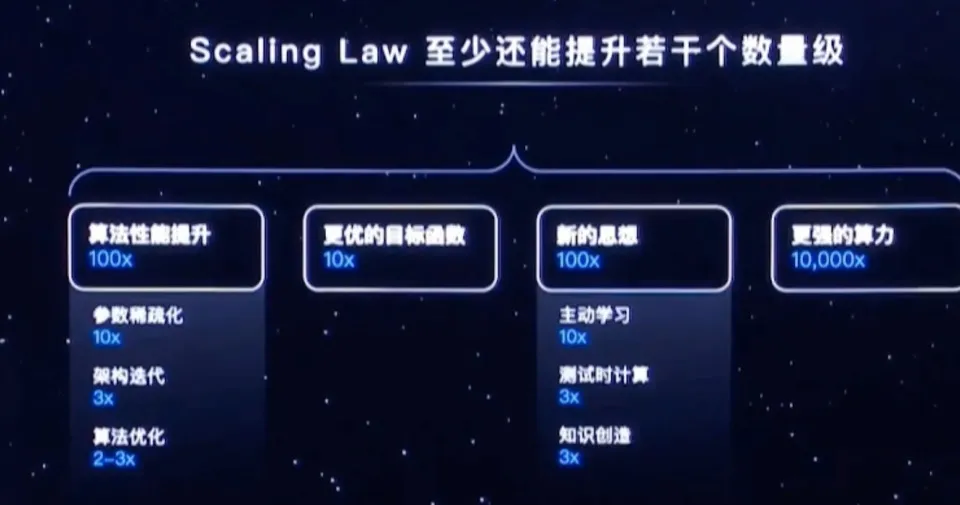

所以像Scaling Law,一方面其实是算力本身的提升,但是如果只是靠算力本身的提升,可能也是不够的。还有另外一个就是算力的利用率或者效率,最终其实是由这两个因素共同来决定,最后模型能做成什么样。

但Scaling并不是说你简单花更多的算力投入在训练上,因为有时候你的算力投入并不能很好的转化成智能。所以它其实是两个问题,一方面是算力怎么持续的去投入,那这里面可能会涉及到,比如说去搭建更大规模的集群,然后每个集群里面的芯片可能有跟更大的本身的计算能力,然后可能第二个很重要的因素就是,每个单位的算力怎么能够发挥出来最大的智能,或者说从算力转换成智能的效率怎么得到提升,比如说你可能用一些主动学习的方式,或者你的架构本身可能是效率更高的,那还可以在Scaling Law基础上去进行叠加,所以最后其实是这两个东西的叠加效果。

我们在这里面观察到,还有一个非常重要的,就是长上下文的技术,类比于计算机时代的内存。

计算机时代的内存也经历了几十年的发展,从大概1970年代,当时很多微计算机只有128K的内存,在今天看起来是非常小的,而且当时确实很多应用是跑不起来。后来可能过了几年,突然出现了512K的内存,那有些应用就可以开始跑了,比如说像当时最早的Excel、Word应用,在1980年代左右就开始出现。然后又经过非常长期,可能三四十年的发展,到现在可能几个G的内存都非常常见。

所以其实长上下文可以理解成就是大模型的内存,就是你一次性能够往大模型里面输入多少token,而token决定了你能参与计算的数量,比如说你可能想一口气阅读一百篇论文,或者你想一口气分析二十篇财报,或者一千份简历想同时去进行处理,或者你希望让Agent能够做一个比较复杂的任务,比如说完成某一个行业的研究报告,那它可能需要去访问很多链接,然后需要在这里面进行推理,进行思考,去完成一个组合式的任务。

这些的背后都需要一个很长的上下文才有办法让它在窗口里面进行推理,然后能够去对更复杂的依赖关系去进行建模,从而完成更加复杂的任务。我们在这个方向上取得了一些小的进展,我们现在能够支持200万字的上下文窗口的输入,为更多的这种应用的可能性,提供了很重要的基础。

它本质上是把熵进行均摊的过程。比如说大家想象,我现在如果想去解一道非常复杂的数学问题,比如说证明哥德巴赫猜想,那你如果只是通过预测一两个token,当你长度很短的时候,你是很难解决问题的,因为他的问题的复杂度非常高。

你需要把很复杂的问题去拆解成一个更长的序列,比如说我把它放到一两百万的token里面去解决,或者说我现在比如说要解一道很复杂的计算题,那你直接去预测答案是很难的,但是我把它拆成很多步去做,那它可能就可以更好的解决这个问题。所以长文本或者说强项效果本身其实就是一个熵的均摊的过程,它可以把一个很复杂的问题,变成一个在长度上进行延伸时,每一步变成一个更简单的问题,就可以去做很好的个性化,比如说每一个人的交互历史可能都可以被记录下来,从而给你提供更个性化的服务。比如说它就可以去做视频生成,就像一小时两小时的视频,它可以在很长的窗口内直接进行建模,那你最最早的十分钟跟最后的十分钟之间的依赖关系,就就可以在中间可以被刻划,所以我们认为它是一个很重要的一个新的技术。

我们现在实际观察到,很多用户在使用AI时会用到具体的一些场景,包括简历的分析,或者说能够让你去快速的去学习一个新的领域,可以去把一些非常专业的文档,或者新的知识作为上文,那接下来的所有的问答,所有的学习过程都可以在这里面去学,能够让你快速的在一个新的领域成为一个专家,这也是一个非常重要的应用场景。

我们判断,接下来可能会有几个重要的方向,也是我觉得整个行业可能会非常关心的几个方向。

首先第一个就是,今天我们如果去看这些大模型产品,它可能很多情情况下仍然停留在比较简单的问答,问他一个问题,比如说Transformer的作者是谁?然后他的核心思想是什么?这些是相对来说比较简单的问题,但是他可能会逐渐延伸到能够去处理一些更长链路的复杂任务。

比如说,我可能就不光只是问他说Transformer做了什么,而是我可能问他说基于Transformer,你帮我去收集一下他最新的进展是什么,然后在上面可能还有哪些研究机会,甚至你能不能把这些研究机会直接去编写成一些代码,甚至去做实验,最后分析实验结果,再反过来跟我一起去讨论?那他可能就会变成一个越来越复杂的任务,在你整个工作流中的渗透,可能从现在的比如说1%,未来有可能提升到90%甚至99%以上。

现在大家在讲Agent,或者是“代理”,它本质上的一个很重要的概念就是,能够去帮你处理很多很复杂的任务,而且甚至不光仅仅只是简单的去遵循你的指令,甚至有可能给你提出来挑战。比如说你给他一个指令,或者给他一个目标,如果你本身指令或者目标有问题,他甚至可能去跟你探讨,可能会更多的像一个人一样跟你一起工作,而不仅仅是被动的去接收你现在想让他去做的任务。

我们认为,从生态的角度来讲,其实硬件和软件也有非常多的新的结合机会,那是不是现在的手机就是最好的硬件载体,还是说未来可能会有新的更好的硬件?随着AI技术的发展,越来越多的模态可以融入到这里面,那是不是可能会有新的机会?我们其实也对会非常非常的期待。

我觉得这里面可能对我们来说,在过去的几年的实践里面很重要的一个点,也是想跟在座的各位创业者去探讨的一个点,就是创业公司怎么能够去更好的发挥优势?很多时候,创业公司最大的优势,甚至可能唯一的一个优势,其实是你的组织,而且组织很多时候是要去适应生产方式的。这种非常适用于新技术,因为当你有新的技术的时候,你的生产方式往往要发生变化,那时候你去从零到一搭建一个新的组织,可能有非常大的优势。

比如说像大模型,它的开发方式跟互联网的开发方式很有可能是完全不一样的,像互联网的开发方式,很多时候你可能是要去做这种规划式的发展,比如说你定一个目标,我接下来要开发什么?很少遇到因为有技术瓶颈导致东西开发不出来。

但是,大模型现在更多的是涌现式的,比如说你要训练到10的25次方的浮点数运算,但是你其实不知道,我训练到节点之后,它能涌现出来什么新的能力。你也不能一个一个案例,每一个分类这样去优化。你可能就是要去更多关注一些基础能力,然后让模型能够去涌现。有点像你不是说直接指一个地方去种一棵树,而是你要直接把整片森林给承包下来,——就是有点这种感觉,所以它的生产方式不一样之后你的组织可能对应是也要做一些调整。

其实很多时候,我们这些新的创业公司反而能够在这里面发挥优势,我们也一直是在方向上去做做探索,然后希望在这里面能够去不断的迭代,出来更大的组织。

然后同时可能很重要的一个点,我们也希望能够在爬楼梯和看风景之间取得一个平衡,因为模型的能力接下来还会有非常大的提升的空间,我们今天可能还是在产业的开端,才刚刚做到10的25次方浮点数运算,那接下来很有可能会有10的26、27、28甚至29次方出现,所以这其实是一个爬楼梯的过程,当然也要平衡,可能有一部分的商业化和产品,但是我们还是希望能够更多的把精力,把优先级放在爬楼梯上,而不仅仅只是去看风景。

非常感谢大家聆听我今天的分享,谢谢。

主持人:请杨植麟留在舞台上,请留步片刻。接下来呢,跟植麟有一个小小的互动,今天的植麟作为我们青年创业者当中的代表,刚才从技术层面给大家做了很多分享。杨植麟是1993年出生,已经是博士了,现在植麟跟他的小伙伴一起,跟大家带来的他们创业的内容,就是现在在国内大火的大模型Kimi,杨植麟是中国35岁以下NLP(自然语言处理)领域引用量最高的一个研究者,这些都不是重点。接下来的重点来了,那这样的一位技术男理工男,在今天学有所成的博士,他儿时的梦想,却是做摇滚歌手和流浪诗人。想问植麟,为什么那个时候想要做一个摇滚歌手或者是流浪诗人,而今天却站在这里跟大家大书特书大模型,来谈科技的未来?这两者之间是一种什么样的关系?

杨植麟:这个问题之前没有彩排过。我觉得可能本质上有一些相通的地方吧,可能都是跟创新有关系,很多时候,包括像有一些摇滚的精神也是一样的,就是我们怎么能够去通过一些新的东西,带来一些增量的不同,因为比如说像摇滚,一开始摇滚发展的时候也是一个全新的流派,代表的是完全不一样的思想,在当时那个时代背景下,其实也有很多这种这种创新,或者说去做做一些新的事情。这样的一种精神,可能我们做技术很大程度上也是这样的一个过程,我觉得对我启发最大的还是摇滚。

当摇滚开始发展很好的时候,刚好正好也是计算机开始发展的时候,当可能是全世界最大市值最高的公司,当时大家形容IBM,说它既是太阳又是月亮还是星星,基本上日月星辰全部被它包揽了。但那时候你没想到居然还有一个新的公司——微软,当时其实就只有几个人,但是他们能够完全去颠覆市场,能够去做一个很颠覆式的创新,我觉得这可能也是我们想要努力的一个方向吧。

主持人:植麟是一个非常典型的“隔壁人家的孩子”,非常非常优秀,在你的成长过程当中,你觉得什么样的核心因素造就了今天的你?

杨植麟:我觉得对于我很重要的,可能还是对创新精神的培养和包容吧,因为很多时候,你创新,就意味着你要想一些很奇怪的想法,但是我觉得比较荣幸说,不管是之前在清华的环境里,还是说现在创业的环境里,其实都能得到很多的包容和支持,我觉得这还是蛮重要的。